SOAR是最近几年安全市场上最火热的词汇之一。SOAR究竟是什么,发展历程是什么,能够起什么作用,带着这些问题我们来认识一下SOAR。

一、SOAR是什么

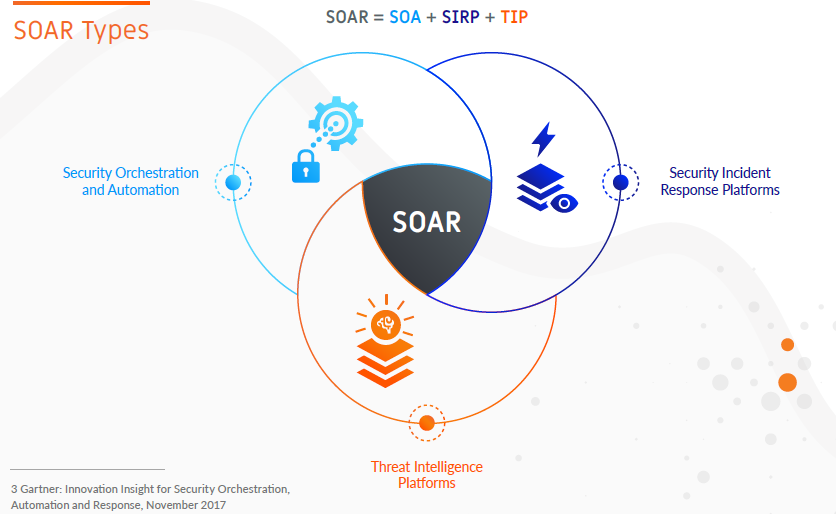

SOAR 一词来自分析机构 Gartner,SOAR-Security Orchestration, Automation and Response 安全编排和自动化响应。在Gartner的报告里,SOAR平台的核心组件为,编排与自动化、工作流引擎、案例与工单管理、威胁情报管理。而SOAR体系则是三个概念的交叉重叠:SOAR=SOA+SIRP+TIP

1)精密编排的联动安全解决方案(SOA);

2)事件应急响应平台(SIRP);

3)威胁情报平台(TIP)。

二、SOAR的发展历程

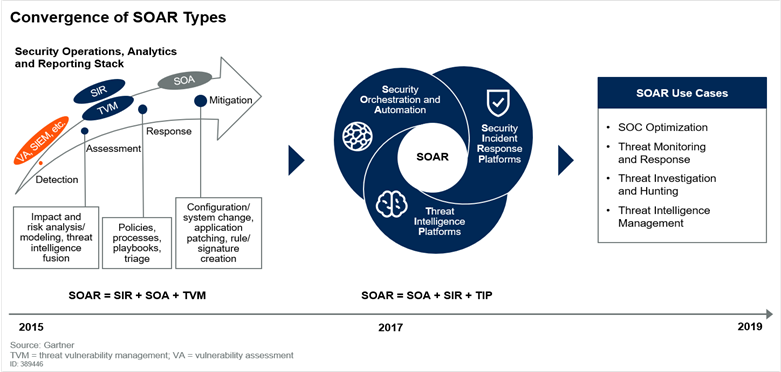

2015年,可以定义为SOAR的1.0时代。Gartner将SOAR(当时被认为是“安全运维分析和报告”)描述成为安全运维团队提供机器可读的安全数据报告和分析管理功能的产品。2017年,SOAR进入2.0时代。Gartner提出了“安全编排、自动化及响应”(SOAR)这个术语,用以描述脱胎于事件响应、安全自动化、场景管理和其他安全工具的一系列新兴平台。Gartner观察到三种以前截然不同的技术:安全编排和自动化(SOA)、安全事件响应平台(SIRPs)和威胁情报平台(TIPs),正在逐步融合到一起。

根据Gartner2019年最新定义,SOAR是指能使企业组织从SIEM等监控系统中收集报警信息,或通过与其它技术的集成和自动化协调,提供包括安全事件响应和威胁情报等功能。SOAR技术市场最终目标是将安全编排和自动化(SOA)、安全事件响应(SIR)和威胁情报平台(TIP)功能融合到单个解决方案中。

根据Gartner预测,到2022年,有30%大型企业组织(安全团队超过5人)将在安全和运维的工作中使用SOAR,这一比例远超当下5%。当下SOAR技术的早期拥护者是那些已经拥有成熟安全运维中心,并且能够理解SOAR带来好处的那些成熟的安全组织。

三、SOAR主要解决什么问题

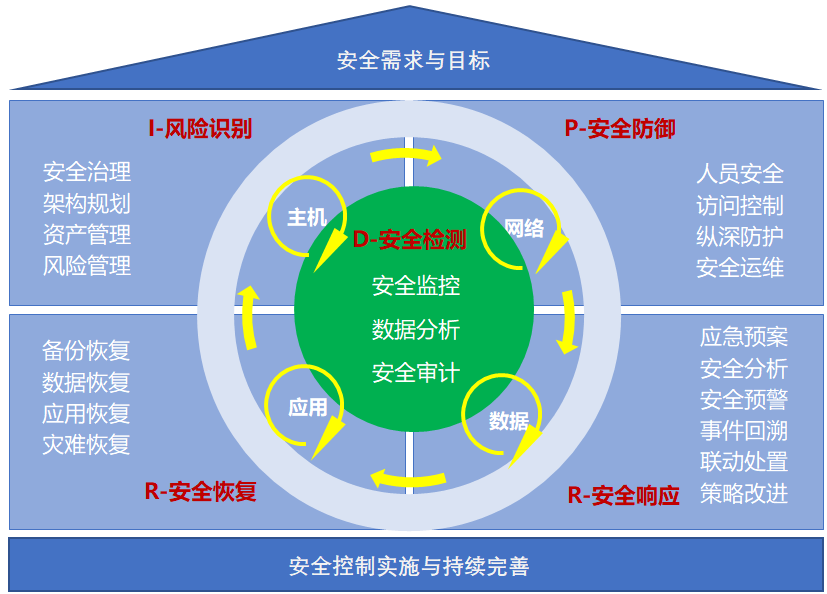

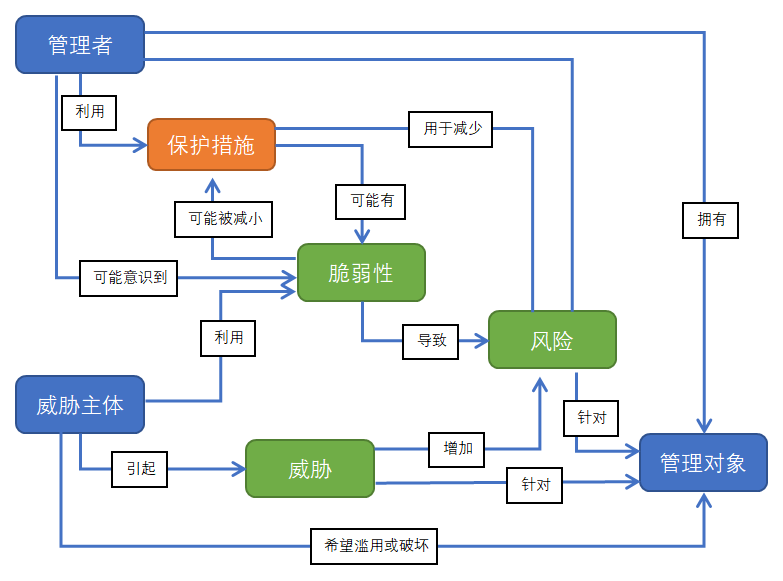

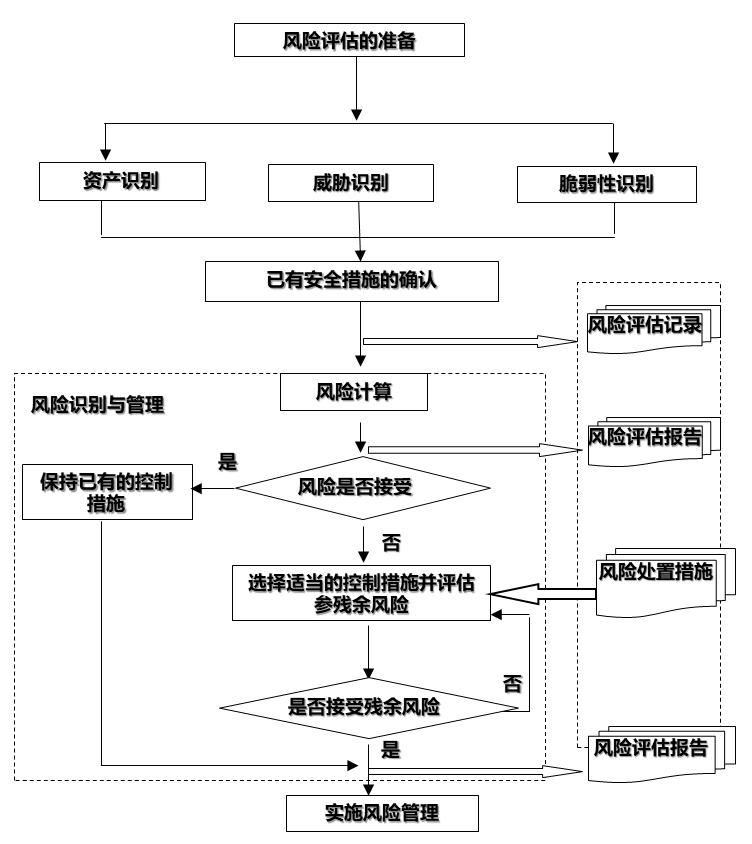

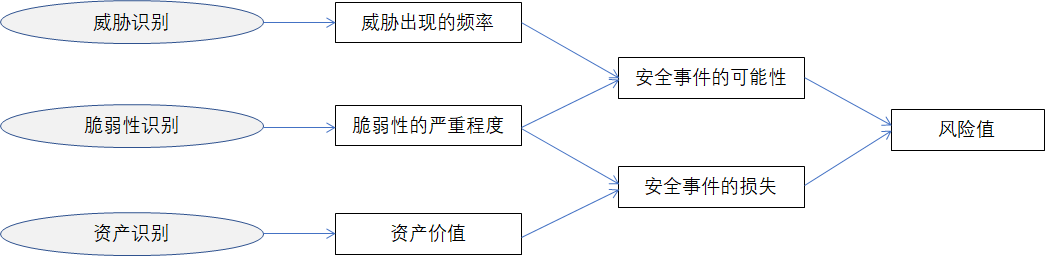

随着网络安全攻防对抗的日趋激烈,网络安全单纯指望防范和阻止的策略已经失效,必须更加注重检测与响应。企业和组织要在网络已经遭受攻击的假定前提下构建集阻止、检测、响应和预防于一体的全新安全防护体系。在国际上,检测和响应类产品受到了极大的关注。放眼国内,更多的注意力集中到了新型检测产品,尤其是未知威胁检测领域。借助这些产品和技术,用户获得了更低的 MTTD(平均检测时间),能够更快更准确地检测出攻击和入侵。但是,这些产品和技术大都没有帮助用户降低 MTTR(平均响应时间)。事实上,对于用户而言,更快地检测出问题仅仅是第一步,如何快速地对问题进行响应更加重要。而在提升安全响应效率的时候,不能仅仅从单点(譬如单纯从端点或者网络)去考虑,还需要从全网整体安全运维的角度去考虑,要将分散的检测与响应机制整合起来。而这,正是 SOAR 要解决的问题。

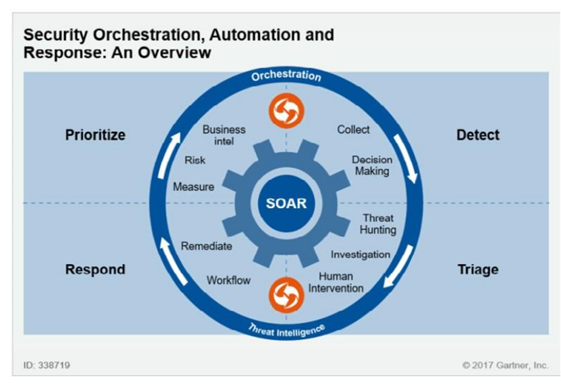

Gartner指出,SOAR可供公司企业收集不同来源的安全威胁数据和警报,运用人机结合的方法进行事件分析与分类,根据标准流程辅助定义、排序和驱动标准化事件响应行为。SOAR主要为安全团队提供定制化的流程和控制,弥合并加速有效网络威胁的调查与缓解。安全运营团队的大量日常事务性工作也可以借助SOAR加以自动化。而且,案例战术手册还可以帮助分析师在单一平台上响应和缓解威胁,节约事件响应的每一分每一秒宝贵时间。

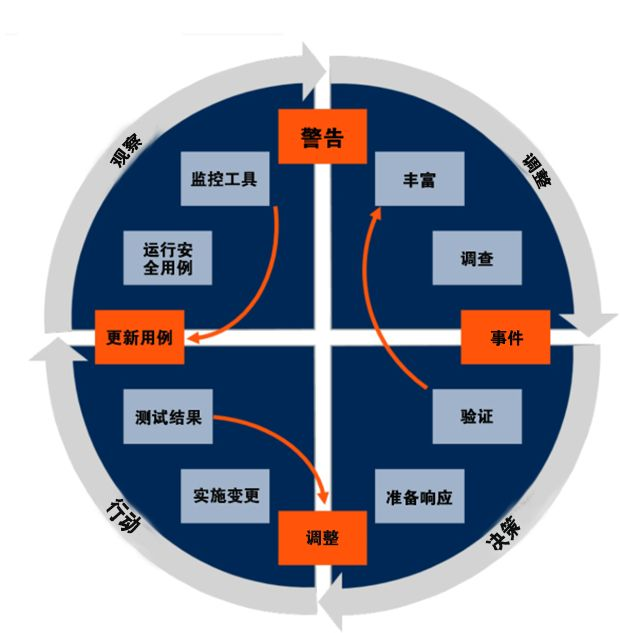

Gartner 用 OODA 模型,来描绘一个典型的安全运营流程。OODA 即 Observe(观察)、Orient(定位)、Decide(决策)、Act(行动)。

- 观察:观察事件并确定发生了什么,即通过各种检测、分析工具,比如 SIEM 类工具,找到威胁线索,如告警。

- 定位:确定观察的方向,并添加上下文来确定观察的含义,即对产生的告警的内容做调查、丰富化。比如查找外网域名的威胁情报,查找此 IP 的历史行为协助研判等等。

- 决策:根据业务的风险容忍度和能力决定适当的响应行动,即判定是否需要对此告警采取行动,比如是否需要封禁,是否影响业务,是否需要进一步观察。

- 行动:根据决定采取行动,并应用到观察过程中,然后重复,即执行确定的安全策略,并验证。每一步都对下一步提供了指导,周而复始,构成了一个良性促进的进化循环,不断优化企业的安全运营流程以应对不断变化的安全威胁。

OODA 环看起来逻辑清晰,易于操作。但事实上, OODA 环里的丰富化、调查取证、验证、执行安全策略变更等等,都是耗时耗力的工作。加上安全设备一直以来的误报问题产生的噪音,以及安全人员工作负荷重,资深从业人员短缺等原因,难以真正有效的推进 OODA 循环。更不用提在 HW 时段高强度的工作压力下,如何能够有条不紊的保持一贯的处置流程来处理每一个安全线索。SOAR 正是在这个背景下被提出,并被寄予厚望。SOAR 的核心,就是将安全流程或预案,即 OODA 循环的每一个实例,比如蠕虫爆发处理流程、挖矿病毒告警处理流程、疑似钓鱼邮件处理流程等等,数字化管理起来形成 Playbook。用自动化完成其中所有可能自动化的动作,无法自动的仍然交由人来处理,通过可视化编排工具将人、技术和流程有机的结合起来,形成标准统一的、可重复的、更高效的安全运营流程。

四、SOAR的核心功能

从SOAR安全编排自动化响应的字面定义来看SOAR应该具备三大核心能力,编排、自动化、响应

编排

SOAR中的关键词是编排,这是在使用自动化和响应之前必须构建的关键组件。SOAR的编排体现的是一种协调和决策的能力,针对复杂性的安全事件,通过编排将分析过程中各种复杂性分析流程和处理平台进行组合。分析涉及多种数据或平台,如SIEM分析平台、漏洞管理平台、情报数据、资产数据等。处置响应的编排也涉及到很多平台或设备,如EDR管理平台、运维管理平台、工单管理平台、WAF设备、防火墙等。仅仅以技术为中心的安全保障已不再能满足现状,将人员和流程的编排才能保证安全流程真正高效的运行。SOAR的终极目标就是实现技术、流程、人员的无缝编排。

自动化

SOAR的自动化体现在三个方面,面对需要处理的安全事件能够根据策略自动选择编排的剧本、自动执行剧本的操作流程、根据决策结果自动联动设备进行防护阻断等行动策略。它允许剧本(常称为Playbooks)在安全流程的部分或全部内容上执行多个任务,将线性剧本串联起来。虽然线性剧本可能更容易创建,但只适用于处理决策需求较少的工作流。编排和自动化比线性剧本的最大优势就是其灵活性,为支持全自动化和半自动化的决策,需要更加灵活的工作流和执行剧本。SOAR能够识别这些决策模式,并基于以往事件中的执行操作,自动推荐新事件的剧本、执行剧本操作流程,自动化分析决策,根据决策结果自动下发防护阻断的行动策略。

响应

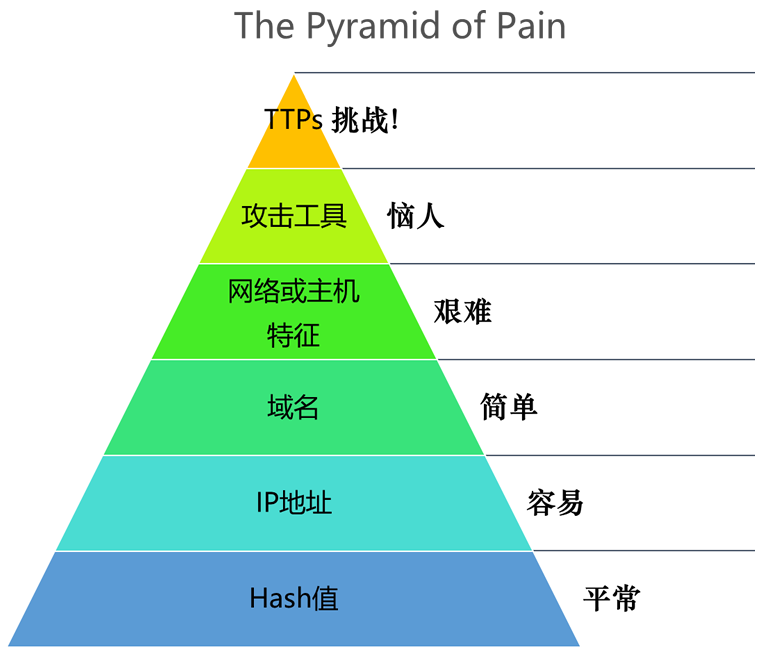

安全事件响应包括告警管理、工单管理、案件管理等功能。告警管理的核心不仅是对告警安全事件的收集、展示和响应,更强调告警分诊和告警调查。只有通过告警分诊和告警调查才能提升告警的质量,减少告警的数量。工单管理适用于中大型的安全运维团队协同化、流程化地进行告警处置与响应,并且确保响应过程可记录、可度量、可考核。案件管理是现代安全事件响应管理的核心能力。案件管理帮助用户对一组相关的告警进行流程化、持续化的调查分析与响应处置,并不断积累该案件相关的痕迹物证 (IOC) 和攻击者的战技过程指标信息 (TTP)。多个案件并行执行,从而持续化地对一系列安全事件进行追踪处置。

事件响应是SOC操作中非常复杂的部分,理想状态下,它将是一个有效的动态过程,涉及数十种相互关联的技术、IT、业务流程和整个组织的人员,将是持续性适应风险和信任评估(Continuous Adaptive Risk and Trust Assessment, CARTA)策略用于在持续监测和可视性方面时,SOC团队可使用SOAR技术执行连续活动,利用SOAR技术通过智能化编排与响应最大程度的将已有安全技术进行整合,提高整个安全事件的解决能力和效率。基于编排和自动化前期对事件的分析,SOAR所提供的响应技术是完善整个事件生命周期,提高解决安全威胁效率的关键一环。本质上,SOAR的最终目标是促进安全团队对事件有全面的、端到端的理解,完成更好、更明智响应。

五、SOAR的价值

1、缩短响应时间

通过自动化技术,尽可能多的自动完成一个安全事件处置流程中相关步骤,从而缩短响应时间即 MTTR。

2、释放人力

让安全专家从繁重的重复劳动中释放出来,将时间放在更有价值的安全分析、威胁猎捕、流程建立等工作上。

3、安全运营流程标准化

将公司的安全运营流程数字化管理起来,每一次安全事件的对应处置过程都在统一标准,统一步骤下执行,有迹可循。避免人员能力的差距导致的处置实际效果不可控。

4、避免能力断层

将安全专家的经验固化成处置预案Playbook,让不同的人都可以遵循同样的方法来完成特定安全事件的处置流程,避免因为个人的离职导致某个领域的安全能力缺失。

5、运营流程指标可度量

因为运营流程都通过 Playbook 数字化管理且每一次的执行过程都记录在案,因此流程的 KPI 如 MTTD、MTTR、TTQ、TTI 等全部可评估、可度量、可追踪。

6、安全运营决策支撑

通过对公司的所有运营流程数字化管理、数字化执行、数字化KPI评估后,管理者可以有效的评估什么流程基本无用,什么流程执行效率不高,什么流程发挥了最大的作用,甚至什么安全设备在所有流程中被使用的价值最大。从而为以后的安全投资决策,安全团队建设决策提供有价值的数值化支撑。

六、SOAR与其他安全产品的关系

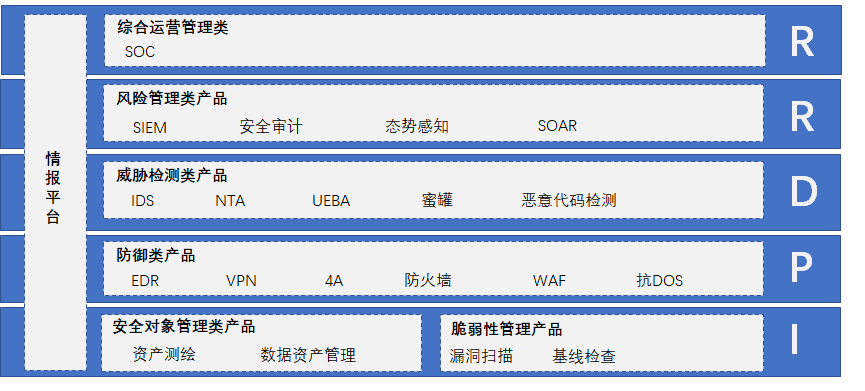

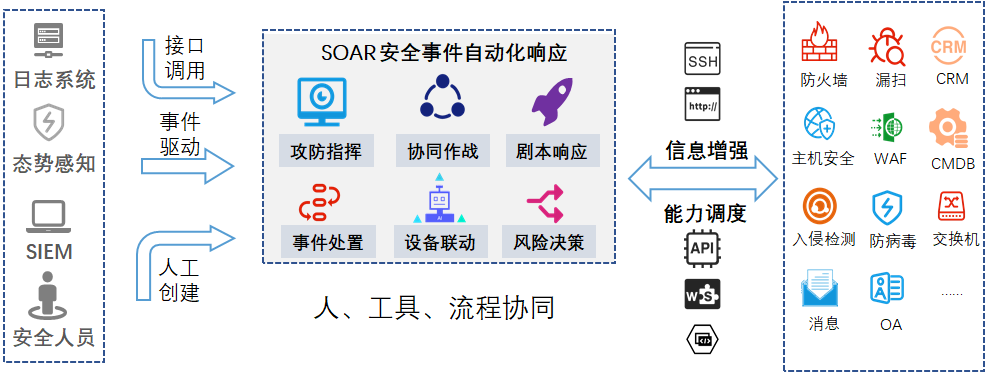

SOAR定位于安全运营操作平台,它收集不同来源的安全威胁数据和警报,事件来源于其他的态势感知平台、SIEM、日志分析系统或安全人员人工录入需要处理的事件。通过调用安全设备的能力如:情报平台、资产管理平台、漏洞扫描平台、EDR管理平台、运维管理平台、工单管理平台、WAF设备、防火墙来实现对安全事件的分析、溯源、取证、处置、通知等。一端接安全事件源,一端对接安全设备能力。通过SOAR本身的编排能力将人员、设备、资源、流程协同起来。每个企业部署流程和技术并不相同,SOAR在实际落地应用过程中并不能“即插即用”,需要对接事件源、对接各类联动处置设备,根据企业具体的实际情况定制剧本流程。对接的实际安全设备能力数量以及剧本的积累,是SOAR平台能够很好的支持运营的关键。