什么是 Claude Code?

Claude Code 是一个智能编码助手,它可以在你的命令行终端中运行。你可以像和真人聊天一样,用自然语言告诉它你想做什么(比如”帮我写一个函数”、”修复这个bug”),它会自动帮你完成代码编写、调试、重构等任务。

主要特点:

- 在终端中直接对话,无需切换窗口

- 自动读取和理解你的项目代码

- 可以直接修改文件、执行命令

- 支持 GLM Coding Plan(智谱 AI 的模型)

前置准备

1. 安装 Node.js(必需)

Claude Code 需要 Node.js 18 或更高版本。

检查是否已安装 Node.js

打开终端(Terminal),输入:

1 | node --version |

- 如果显示版本号(如

v18.x.x或v20.x.x),说明已安装,可以跳过这一步 - 如果提示”命令未找到”,需要先安装 Node.js

安装 Node.js

Mac 用户推荐方式:使用 nvm(版本管理器)

nvm 可以让你在同一台电脑上安装和管理多个 Node.js 版本。

安装 nvm:

1

curl -o- https://raw.githubusercontent.com/nvm-sh/nvm/v0.39.0/install.sh | bash

重新打开终端,或执行以下命令使 nvm 生效:

1

2export NVM_DIR="$HOME/.nvm"

[ -s "$NVM_DIR/nvm.sh" ] && \. "$NVM_DIR/nvm.sh"安装最新的 Node.js LTS 版本:

1

2nvm install --lts

nvm use lts设置为默认版本:

1

nvm alias default lts/*

Mac 用户备用方式:使用 Homebrew

1 | # 如果没有安装 Homebrew,先安装它 |

Windows 用户:

- 访问 Node.js 官网

- 下载 LTS 版本(长期支持版)

- 运行安装程序,一路”下一步”即可

同时安装 Git for Windows(Windows 用户必需):

- 访问 Git 官网

- 下载并安装,使用默认设置即可

安装 Claude Code

方式一:npm 命令行安装(推荐)

打开终端(Mac/Linux)或 PowerShell/CMD(Windows)

执行安装命令:

1

npm install -g @anthropic-ai/claude-code

验证安装是否成功:

1

claude --version

如果显示版本号(如 2.0.14),说明安装成功!

方式二:使用 Cursor 编辑器引导安装

如果你有 Cursor 编辑器但不熟悉命令行:

- 打开 Cursor

- 按

Cmd + L(Mac)或Ctrl + L(Windows)打开聊天面板 - 输入:

Help me install Claude Code - Cursor 会引导你完成安装过程

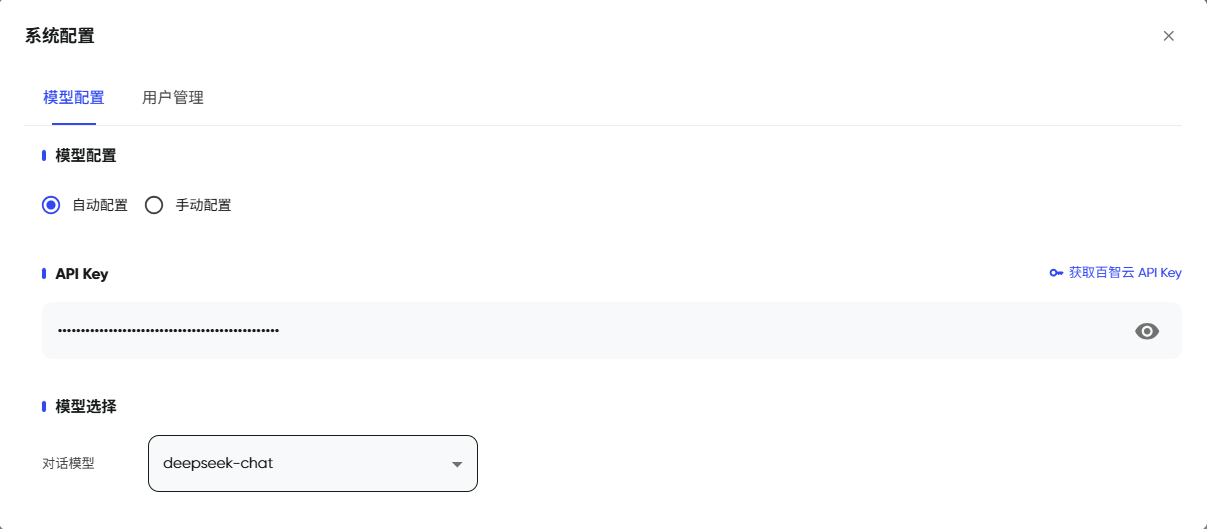

配置国内模型

Claude Code需要接入大模型才能发挥作用,对于国内环境各个模型大厂都推出了Coding Plan套餐,以下以智谱AI的为例,安装完成后,需要配置智谱 AI 的 API Key 才能使用GLM-5模型。

获取 API Key

- 访问 智谱 AI 开放平台

- 注册/登录账号

- 进入”API Key”管理页面

- 创建新的 API Key 并复制保存

配置方式

启动 Claude Code:

1

claude

首次启动会提示配置 API,选择”Manual setup”或手动配置

配置环境变量:

1

export ANTHROPIC_API_KEY="你的API_Key"

Windows PowerShell 用户:

1 | $env:ANTHROPIC_API_KEY="你的API_Key" |

- 永久保存配置(推荐):

创建或编辑配置文件 ~/.claude/settings.json(Mac/Linux)或 %USERPROFILE%\.claude\settings.json(Windows):

1 | { |

开始使用

1. 启动 Claude Code

进入你的项目目录,然后运行:

1 | cd /path/to/your/project |

2. 首次启动

- Claude Code 会询问是否信任该目录,选择 “Trust” 或 “Yes”

- 这样 Claude Code 才能读取和修改你的项目文件

3. 基本使用

启动后,你可以直接输入自然语言命令:

示例:

1 | > 帮我写一个 Python 函数,计算斐波那契数列 |

常用命令:

/help- 查看帮助信息/status- 查看当前配置和状态/exit- 退出 Claude Code

切换模型(可选)

Claude Code 支持多种智谱 AI 模型,你可以手动切换。

修改配置文件

编辑 ~/.claude/settings.json:

1 | { |

模型说明:

glm-4.5-air:轻量级模型,响应快速,适合简单任务glm-4.7:主力模型,平衡性能和质量glm-5:最新模型,能力最强,适合复杂任务

验证配置

重新启动 Claude Code,输入 /status 查看当前使用的模型。

常见问题

Q1: npm install 提示权限错误(Mac/Linux)

解决方案:

1 | # 使用 sudo 安装(不推荐,但最简单) |

Q2: 配置文件修改后不生效

解决步骤:

- 关闭所有 Claude Code 窗口

- 重新打开终端

- 再次运行

claude启动 - 如果问题仍存在,删除

~/.claude/settings.json,重新配置

Q3: 如何升级到最新版本?

1 | # 检查当前版本 |

推荐使用最新版本以获得最佳体验。

Q4: Windows 下提示找不到 claude 命令

解决方案:

- 确保 npm 全局安装路径在系统 PATH 中

- 查找 npm 全局路径:

npm config get prefix - 将该路径下的

bin目录添加到系统环境变量 PATH 中 - 或使用 PowerShell 重新安装:

npm install -g @anthropic-ai/claude-code

Q5: 如何在项目中使用?

进入任何项目目录后启动:

1 | cd /path/to/your/project |

Claude Code 会自动扫描并理解项目结构,可以帮你完成:

- 代码生成和补全

- Bug 修复和调试

- 代码重构和优化

- 添加注释和文档

推荐工作流

日常开发流程

启动项目

1

2cd my-project

claude描述需求

1

> 帮我创建一个用户登录页面,使用 HTML + CSS + JavaScript

迭代优化

1

2> 给登录按钮添加 hover 效果

> 添加表单验证功能调试问题

1

> 为什么点击登录后没有反应?帮我检查代码

团队协作

- Claude Code 可以读取整个项目代码库

- 可以帮你理解别人的代码

- 可以协助 Code Review

- 可以生成文档和注释

进阶配置

配置视觉 MCP 服务器(图片识别)

如果你需要让 Claude Code 识别和分析图片,可以配置视觉 MCP 服务器。

参考文档:视觉MCP服务器

配置搜索 MCP 服务器(联网搜索)

如果你需要让 Claude Code 搜索最新信息,可以配置搜索 MCP 服务器。

参考文档:搜索MCP服务器

配置网页读取 MCP 服务器

如果你需要让 Claude Code 读取网页内容,可以配置网页读取 MCP 服务器。

参考文档:网页读取MCP服务器

总结

安装 Claude Code 只需要三步:

- ✅ 安装 Node.js 18+

- ✅ 运行

npm install -g @anthropic-ai/claude-code - ✅ 配置智谱 AI API Key

安装后,在任何项目目录运行 claude 即可开始使用!

参考资源

作者博客:http://xiejava.ishareread.com/

关注:微信公众号,一起学习成长!

![\[图片\]](http://image2.ishareread.com/images/2025/20251219/1-phpIPAM%E5%8A%9F%E8%83%BD.png)