随着数字化转型加速,企业的IT环境日益复杂,面临的网络安全威胁也在不断增加。传统的防御措施已经无法有效应对新型威胁,而且很多企业缺乏专业的网络安全团队和技术手段,导致大量的安全事件未能及时被发现和处理。

在这种背景下,托管威胁检测响应服务(MDR)应运而生。MDR能够利用现代安全运营中心的技术和专业人员,为客户提供全天候的安全监测和快速响应,从而缩短威胁发现和响应之间的窗口期,降低风险并减轻安全运营压力。

那么什么是MDR,MDR都包含了什么?MDR又与XDR是什么关系,与MSS又有什么区别?带着这些问题我们来了解托管威胁检测与响应(MDR)

一、什么是MDR

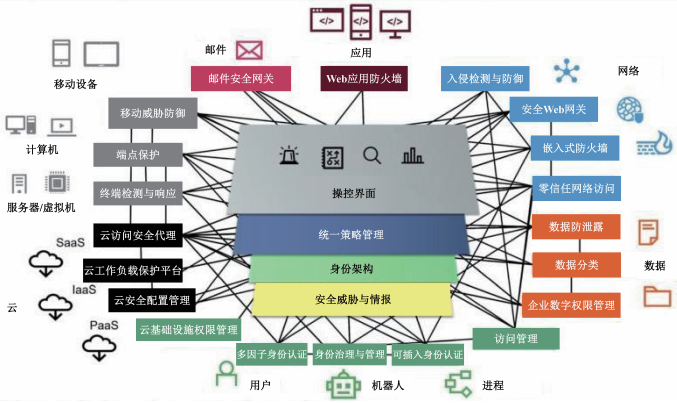

托管威胁检测与响应(Managed Detection and Response,托管检测与响应)是一种外包服务,旨在提供7x24小时的网络安全事件监测和分析,快速发现威胁并进行有效的响应。它结合了分析和人类专业知识来检测和消除网络中的威胁。大多数MDR服务通过主机层与网络层的威胁监测与分析技术,生成、收集安全事件以及上下文数据,结合安全运营平台的数据分析技术和安全运营专家的技术力量共同完成。

通俗一点讲,就是一些中小企业受制于在人员、时间、技能、资金、流程等方面的缺失,将企业自身的安全威胁检测与响应的活委托给安全服务商(Managed Security Service Provider, MSSP),通过外部托管安全服务提供商(MSSP)提供专业知识并填补安全架构空白,从而解决许多企业网络安全专家短缺技能不足的问题。从趋势上看,越来越多的企业转向选择MDR,由此获得最大化的投入产出效果。

倾向于采用MDR的企业的几种情形:

- 没有安全运营团队,因此希望将安全监控运营外包给专门从事该领域的第三方;

- 安全运营团队人数有限,但通过MDR提供商,就能确保团队不必承担大多数一线工作负担以及众多其他安全运营工作任务,而是能够更加专注于服务输出;

- 有安全运营团队,可以自己进行全天候监控。尽管如此,他们仍希望将一线威胁检测工作转交给专门从事这项工作的公司。

二、MDR都包含了些什么

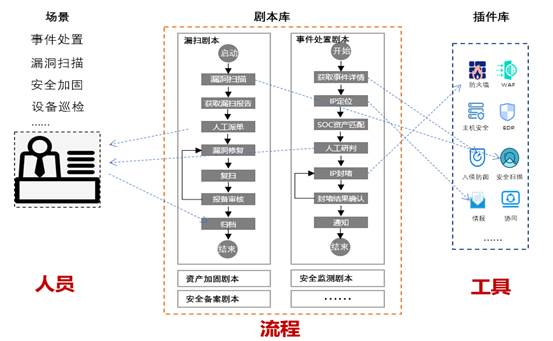

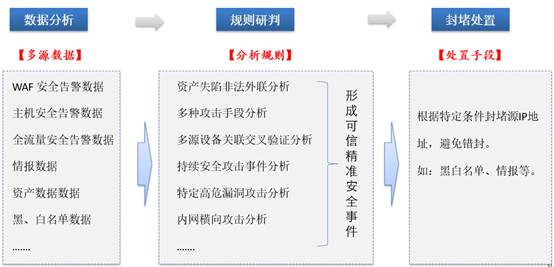

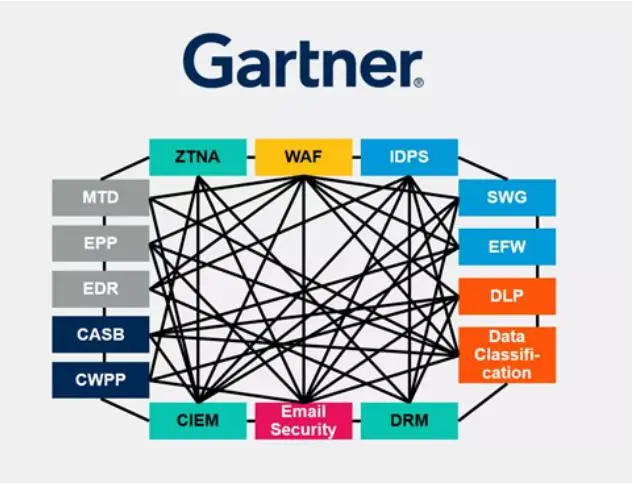

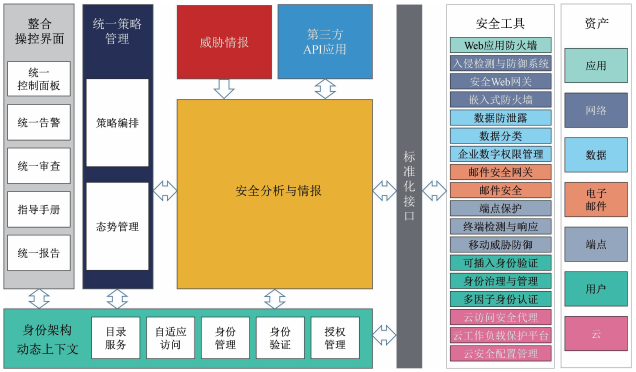

Gartner将托管威胁检测与响应(MDR)其描述为通过7x24小时全天候不间断的监控和覆盖,建立起快速威胁检测与有效响应的服务。绝大多数MDR服务是通过主机层与网络层的技术生成、收集安全事件以及上下文数据,支持威胁检测与事件分析。

MDR服务一般包含以下内容:

- 实时威胁检测:MDR服务提供实时监控和分析网络流量、系统日志以及其他安全事件的能力。

- 威胁狩猎:威胁狩猎力图在威胁访问关键数据之前发现威胁,通过使用先进的威胁情报和分析工具,识别潜在的安全威胁,包括已知的和未知的威胁。

- 威胁情报分析:情报是了解攻击者及其攻击方式的关键。安全团队通过威胁情报可以更好地了解特定的攻击者及其常用的战术、技术和流程 (TTP),从而更有效地防御威胁;

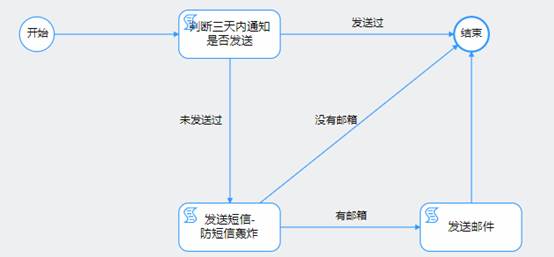

- 事件响应:MDR服务不仅仅是关于检测威胁,还包括对安全事件的响应。一旦检测到潜在威胁,MDR团队会采取相应的措施,可能包括隔离受感染的系统、清除恶意代码,以及协助客户制定恢复计划。

- 全覆盖范围:MDR提供24/7/365持续服务,分析师可以在白天或晚上的任何时间做出响应;

- 专业知识:MDR不仅提供基于用户安全工具产生的日志的检测服务,还提供专业的安全人员对相关事件进行快速调查和响应;

- 实时可见性:MDR产品需要精细的实时端点可见性来捕捉和阻止攻击者。

MDR充分利用客户侧已部署的终端、边界、流量等防护设备,通过行为分析、流量分析、威胁情报以及与多级专家的组合,为客户提供更加快速和全面的威胁监视、检测和响应服务。MDR服务具有现代安全运营中心远程交付的能力,专注于精准检测、调查分析、积极遏制事件,旨在通过持续运营以减少威胁发现和威胁响应之间的时间。

MDR服务不仅限于更强的检测和响应能力,它还可以为不堪重负的安全团队提供主动防御情报和高级威胁洞察。企业还可以使用MDR服务来应对合规挑战,因为它提供有关各种法规和标准的完整报告和日志保留。

三、MDR与XDR的关系

XDR全名是Extended Detection and Response(扩展检测和响应)Gartner给出的XDR定义为:XDR是一种基于SaaS的、绑定于特定供应商的安全威胁检测和事件响应工具,它将多个安全产品集成到一个统一了所有许可安全组件的内聚安全运营系统中。

通常情况下,可以认为XDR是一个融合了多种安全检测、响应能力的平台框架,只要是为了解决威胁检测与响应的问题能力模块,都可以往里装。特别的强调X的概念,也就是可以 扩展(Extended)的检测与响应。大家都知道在数学里通常用X表示变量,这里X覆盖了云、网、端、威胁情报等,EDR和NDR及其他的检测设备都可以作为XDR的能力模块作为X为XDR提供数据来源和检测手段。实际在威胁检测与响应的过程中人也是重要的环节,除了EDR、NDR,MDR中的M也可以认为是X的一种。

MDR是一种托管检测和响应服务,通过外部托管安全服务提供商(MSSP)提供专业知识并填补安全架构空白,解决许多企业网络安全专家短缺的问题。MDR帮助公司保持监控状态,预测并防止潜在的网络攻击。

XDR是一种更强大的网络安全解决方案,可从多个来源收集和分析数据,以预防、检测和响应网络攻击。XDR是端点检测和响应(EDR)的演进版本,通过以标准格式汇集历史和实时事件数据来提高安全团队的效率和生产力。XDR超越了EDR,具有跨网络的检测和缓解功能,可有效保护企业的整个数字环境,包括网络、云存储、应用程序和端点。XDR提供多种类型的检测,特别适合那些现有解决方案无法覆盖所有攻击面的的企业。XDR支持可扩展的高性能存储、快速索引搜索和自动化驱动的威胁响应,经常以软件即服务(SaaS)的形式提供,使企业更容易使用该技术。

总的来说,MDR和XDR都是用于检测和响应网络安全威胁的解决方案,但XDR概念更大,是一个覆盖了所有能够解决威胁检测与响应的框架,而MDR托管检测和响应服务更加强调的是人和服务。MDR是通过使用各种XDR的工具和模块如EDR、NDR或其他工具和手段来实现威胁的检测和响应服务。

四、MDR与MSS的区别

Garter将MDR服务描述为:为客户提供远程交付的现代安全运营中心(MSOC)功能,通过提供24/7连续监测来在建立和改进有效的早期威胁检测和响应。

MSS(Managed Security Service,托管安全服务)由来已久,主要是由托管安全服务商( MSSP)对企业的安全设备及系统进行外包的监控和管理,常见的服务包括托管防火墙、入侵检测、虚拟专用网络、漏洞扫描以及反病毒服务。

MDR(托管威胁检测与响应)和MSS(托管安全服务)是两种不同的安全服务,虽然它们的目标都是帮助组织提高安全性,但在实现方式和关注点上还是存在一些区别。以下是它们的主要区别:

1.关注点不同:

- MDR: MDR的主要关注点是在网络和系统中主动检测和应对威胁。它强调实时监控、威胁检测和迅速的响应。MDR通常更加注重对威胁的深度分析和处理。

- MSS: MSS关注的范围更广泛,包括安全信息与事件管理(SIEM)、日志管理、设备管理、合规性管理等。MSS的目标是提供一种全面的、托管的安全解决方案。

2.响应方式不同:

- MDR: MDR强调对安全事件的主动响应。一旦检测到威胁,MDR服务提供商通常会采取行动,协助客户隔离受影响的系统、清除恶意代码,并支持恢复操作。

- MSS: MSS更侧重于对事件的收集、监控和报告,而不一定强调实时响应。它通常提供日志管理、合规性报告等功能,用于长期的威胁分析和合规性要求。

3.服务深度不同:

- MDR:MDR服务通常更深度地涉及威胁检测和响应,可能包括使用先进的威胁情报、行为分析、终端检测与响应(EDR)等技术。

- MSS:MSS更广泛地覆盖了安全服务的多个方面,包括日志管理、漏洞管理、合规性管理等。它可能更注重对整个安全生态系统的全面管理。

4.技术要求不同:

- MDR: MDR通常需要使用更先进的威胁检测技术,可能包括机器学习、行为分析、沙箱技术等,以及对安全事件的实时响应能力。

- MSS: MSS可能更注重于传统的安全技术,如防火墙、入侵检测系统(IDS)、反病毒软件等,同时也包括SIEM等辅助工具。

总体而言,MDR更注重在发生安全事件时的实时响应和深度分析,而MSS则更广泛地提供安全服务,包括对整个安全基础设施的管理和监控;MSS主要关注预防,而MDR则更注重检测和响应;MSS的服务宽且浅,MDR的服务窄且深。

Gartner认为MSS和MDR是交集的关系,MSS尚不会完全覆盖MDR服务。两者之间最大的区别在于,MSS服务在发现威胁或告警的时候,会通知企业自行处置,而MDR则会利用自身的技术去完成对威胁的检测,帮助企业完成响应和处置的工作。不过,随着托管安全服务的发展,这两种服务之间的界限越来越模糊,很多MSS厂商也开始提供MDR服务。

作者博客:http://xiejava.ishareread.com/

关注:微信公众号,一起学习成长!